O algoritmo do Google está em constante desenvolvimento, o que se reflete perfeitamente na sua longa história de atualizações. A mais recente, conhecida como Bidirectional Encoder Representations from Transformers (BERT), é a maior evolução na forma de entender as pesquisas no Google Search desde o lançamento do RankBrain.

O Google BERT é o novo modelo de processamento de linguagem natural com o qual o motor de pesquisa pretende compreender a linguagem humana, tanto escrita como falada. O objetivo da empresa Mountain View é poder responder às queries mais complexas, aquelas cuja intenção de busca está na compreensão de toda a frase e não apenas da palavra-chave.

Como funciona o Google BERT?

O Google tem baseado tradicionalmente o seu algoritmo de search na análise isolada das keywords utilizadas. Ou, por outras palavras, quando alguém fez uma consulta, o Google rastreou as suas bases de dados até encontrar o conteúdo que mais se aproximava das palavras-chave.

Com o BERT, isto muda. O significado individual de cada palavra ocupa um lugar secundário, e é o significado da frase como um todo que o algoritmo dá prioridade. Por conseguinte, a Google continuará a analisar as palavras, mas fá-lo-á conjuntamente, tendo em conta o contexto em que se encontram.

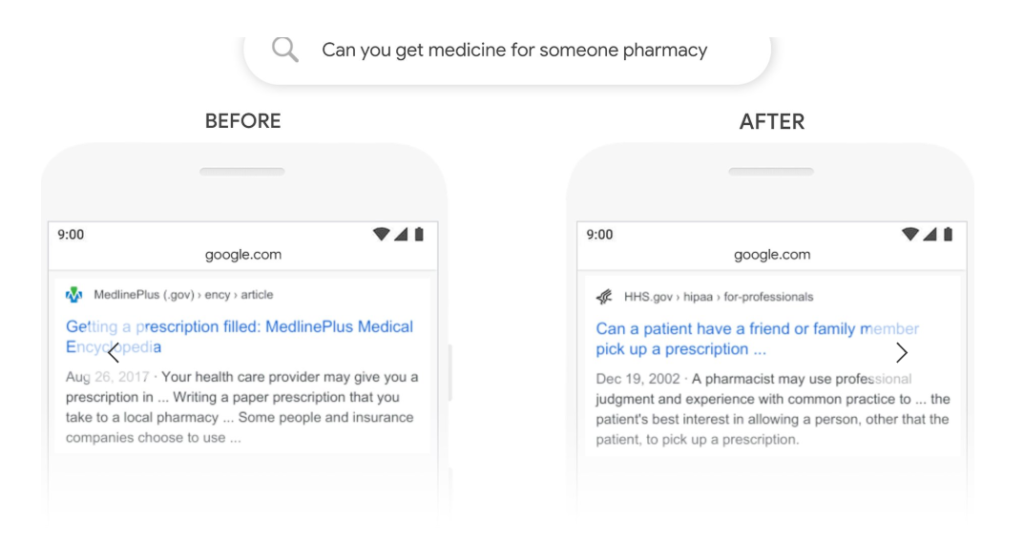

O exemplo seguinte, que o próprio Google oferece no seu blog oficial, mostra como funciona o BERT:

Mas como é que o Google BERT consegue compreender o verdadeiro significado de uma frase? Para responder a esta pergunta, analisámos exaustivamente o significado de dois dos conceitos que compõem o acrónimo BERT:

1. (B)idirecional

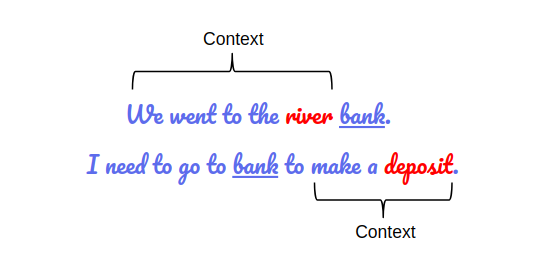

O BERT analisa o texto nos dois sentidos: tem em conta as palavras à esquerda e à direita de cada keyword. Desta forma, ao relacionar todas as palavras umas com as outras, ele é capaz de processar um contexto muito mais profundo. É uma questão de interpretação semântica global.

Para o explicar melhor, tomamos um exemplo representativo da Analytics Vidhya. Como pode ser visto na frase seguinte, o significado da palavra “bank” muda de acordo com o contexto da frase. E, embora “bank” seja a keyword, o BERT terá em conta as palavras circundantes para dar uma resposta mais precisa à intenção de pesquisa.

2. (T)ransformadores

Os transformadores são uma rede neural de modelos de processamento de linguagem natural (NLP, Natural Language Processing). A Google tem vindo a utilizar este tipo de inteligência artificial com o RankBrain há já algum tempo, mas agora evoluiu. Ao contrário do NLP de 2015, que tinha uma função textual, o NLP do BERT funciona como um sistema de atribuição de significado que ajuda o algoritmo a compreender certas palavras, como nexos, pronomes ou preposições.

Na linguagem humana, os conectores são indispensáveis para dar sentido à mensagem. Antes, o Google evitava-as e concentrava-se em keywords individualizados. Com o BERT, agora o significado de cada palavra introduzida no motor de busca depende dos conectores que a acompanham.

Matías Pérez Candal, Director de Estrategia em Labelium Espanha

As pesquisas mais ambíguas e long-tail beneficiarão muito, uma vez que os conectores são capazes de dar sentido a palavras que, individualmente, o algoritmo não poderia compreender bem. Por conseguinte, os resultados serão mais relevantes e ajustados ao que o utilizador está a tentar descobrir.

Como focar a otimização SEO com o Google BERT

Na verdade, o Google BERT afeta a compreensão das pesquisas por parte dos utilizadores. Considerando a lógica subjacente a esta atualização (responder às buscas de uma forma mais humana), é possível utilizar o princípio de que parte para atrair tráfego de maior qualidade.

Como Neil Patel comenta no seu blog: o importante é que o utilizador, não o motor de pesquisa, compreenda conteúdos valiosos. Para tal, é aconselhável ter em mente as seguintes orientações:

- O conteúdo deveria ser mais conversacional. Os textos têm de ser orientados para as pessoas e não para o motor de busca, pelo que é muito conveniente escrever com um estilo natural.

- O website deve ser estruturado de forma a que a intenção de pesquisa seja prioritária. As keywords continuam a ser importantes, mas já não são o objetivo final do texto. Agora devem ter uma razão de ser e não só o número de vezes que são repetidas no texto será recompensado.

- É essencial dar uma resposta real e útil às questões colocadas. Se o Google BERT for capaz de compreender o significado da pesquisa e a intenção por detrás dela, é lógico pensar que o conteúdo alcançará um público mais segmentado, mas mais afim.

O BERT irá mudar a forma como entendemos o SEO em 2020? Há ainda muito por explorar, embora a direção que a indústria está a tomar prometa uma transformação inevitável no sentido de uma visão mais user-centric nas estratégias SEO.